Robots.txt क्या होता है ? What is Robots.txt?

Robots.txt एक text फाइल होता है जो कि किसी भी वेबसाइट या ब्लॉग के रूट फोल्डर में मौजूद रहता है। यह search engine bots को instruction देता है की वेबसाइट या ब्लॉग के किस भाग को crawl करना है या नहीं।

Robots.txt फाइल search engine bots को यह बताता है की crawler वेबसाइट के किन किन URL तक पहुंच सकता है। मुख्यतः इसका उपयोग instruction देना और वेबसाईट पर overloading को कम करने के लिए किया जाता है।

Robots.txt फाइल को वेबसाइट या ब्लॉग के root directory में अपलोड किया जाता है जो की text फॉर्मेट में होता है।

Robots.txt क्यों आवश्यक है? Importance of Robots.txt

- Robots.txt फ़ाइल search engine bots को यह instruction देता है की वेबसाइट या ब्लॉग के किस हिस्से को crawl करना है और किस हिस्से को नहीं।

- इसकी मदद से किसी खास फाइल,फोल्डर,इमेज,पीडीएफ या किसी अन्य अनिवार्य फाइल को सर्च इंजिन में इंडेक्स होने से रोका जा सकता है।

- कभी-कभी वेबसाइट के पेजेस या पोस्ट को index करने में अधिक समय लगता है जिसमें क्रॉल बजट की समस्या हो जाती है। इस समस्या से बचने के लिए robots.txt फाइल का यूज कर सकते हैं जिसमें हम उन सभी unimportant पेजेस या पोस्ट को ब्लॉक कर सकते हैं जिन्हें हमें index नहीं कराना है। इससे फायदे ये होंगे की search engine bots अपने crawl बजट का अधिक हिस्सा उन पेजेस या पोस्ट पर खर्च करेगा जो वास्तव में महत्वपूर्ण होंगे।

- Robots.txt फ़ाइल के द्वारा हम search engine को यह भी बता सकते हैं कि वेबसाइट या ब्लॉग की sitemap कहां स्थित है।

- इस फाइल के मदद से वेबसाइट या ब्लॉग के किसी भी सेक्शन को प्राइवेट किया जा सकता है।

- वेबसाइट या ब्लॉग के low quality पेजेस को ब्लॉक करके SEO में भी सुधार किया जा सकता है।

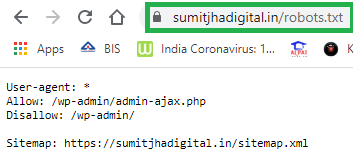

Robots.txt फाइल कहां स्थित रहता है?

Robots.txt फ़ाइल वेबसाइट के रूट फोल्डर में मौजूद रहता है। यदि आपको पता नहीं है कि आपके वेबसाइट में robots.txt फाइल मौजूद है या नहीं तो सर्च इंजन बार में बस आपको यह टाइप करना है- www.xyz.com/robots.txt

जैसे ही आप ऊपर दिए हुए इंस्ट्रक्शन को टाइप करेंगे तो आपके सामने एक text पेज खुल कर आएगा जैसा कि आप स्क्रीनशॉट में देख सकते हैं।

Robots.txt फाइल के syntax क्या क्या हैं?

1) User-agent: *

Disallow: /

अगर हमें सभी वेब क्राउलर या search engine bots को वेबसाइट के crawl करने से रोकना है तो हम Robots.txt फाइल में इस कमांड का उपयोग करेंगे।

2) User-agent: *

Disallow:

अगर हमें वेब क्रॉलर या search engine bots को वेबसाइट के सभी पेज या पोस्ट को crawl करने की अनुमति देना है तो हम robots.txt फाइल में इस कमांड का उपयोग करेंगे।

3) User-agent: Googlebot

Disallow: /xyz-subfolder/

अगर हमें गूगल के क्रॉलर को xyz-subfolder को crawl करने से रोकना है तो हम robots.txt फाइल में इस कमांड का उपयोग करेंगे।